腾讯云TI平台TI-ONE采用NVIDIA Triton推理服务器构建高性能推理服务部署平台,让用户轻松部署包括TNN模型在内的多种深度学习框架。该方法下得到的AI模型显着提升了推理服务的吞吐量,提高了GPU利用率。

腾讯云TI平台(TencentCloud TI Platform)基于腾讯先进的AI能力和多年的技术经验,是开发者的综合平台、政府和企业。堆叠人工智能开发服务平台致力于连接行业+从数据采集、数据处理、算法构建、模型训练、模型评估、模型部署,到AI应用开发。 AI实施的全流程环节,帮助用户快速创建和部署AI应用、管理全周期AI解决方案,从而帮助政企单位加速数字化转型,推动AI产业生态共建。腾讯云TI平台系列产品支持公有云接入、私有化部署和专用云部署。

TI-ONE是腾讯云TI平台的核心产品之一。是为AI工程师打造的一站式机器学习平台,为用户提供数据接入、模型训练、模型管理到模型服务的全流程开发支持。腾讯云TI平台TI-ONE支持多种训练方法和算法框架,满足不同AI应用场景的需求。

通常我们训练完AI模型后,需要将其部署在云端,形成AI服务,可以被应用客户端调用。然而,如何高效部署推理服务无疑是AI推理平台需要面对的挑战。

一方面,推理服务部署平台需要支持多种不同深度学习框架训练的模型,以满足不同客户对不同框架的偏好,甚至需要支持一些定制的推理框架,例如TNN[1] 。

另一方面,部署平台需要尽可能提高推理服务的性能,包括提高吞吐量、降低延迟、提高硬件资源利用率等。这就需要平台部署和部署有效地安排模型。优化。

最后,对于前处理、后处理、AI模型等多个模块组成的工作流程,例如,有些AI工作流程中除了深度学习模型外,还包括前处理、后处理模块,推理服务部署平台也需要各模块有序高效实施。系列中。上述需求需要推理服务部署平台的精心设计和实现。

针对上述挑战,腾讯云TI-ONE充分利用NVIDIA Triton推理服务器构建高性能推理部署解决方案,以提高多个行业场景的推理工作负载效率。

腾讯云将 Triton 集成到 TI-ONE 的推理部署服务中。行业客户只需将需要推理的模型上传到TI-ONE平台,并选择使用Triton作为推理后端框架即可。 TI-ONE 可以自动拉取 Kubernetes 集群上的 Triton 容器。在容器内,Triton 服务器会根据客户选择的配置参数启动并自动加载用户上传的模型,并将其作为模型实例进行管理,并提供外部推理服务请求接口。

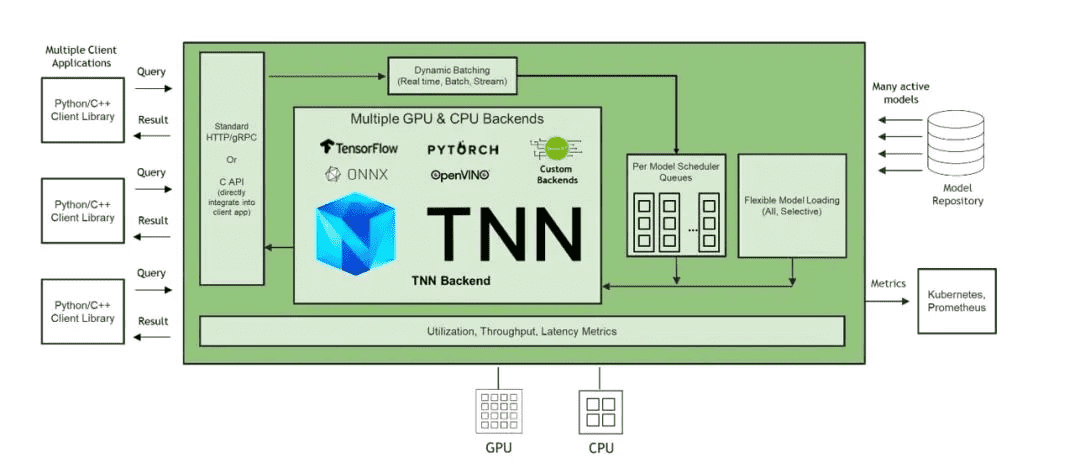

Triton支持大多数主流深度学习框架的推理,包括TensorRT、TensorFlow、PyTorch、ONNX Runtime等。此外,Triton还支持扩展自定义推理框架Backend。 TNN是腾讯开发的开源高性能、轻量级神经网络推理框架。广泛应用于腾讯云行业解决方案的推理场景。腾讯云沿袭Triton Backend API[2],实现了Triton TNN Backend,使得TNN模型可以直接由Triton推理服务器加载、管理和执行。

图1. 添加TNN后端的Triton推理服务器架构示意图

为了提高推理服务的性能,提高硬件资源利用率,腾讯云TI-ONE使用了Triton提供的Dynamic Batching功能。在部署推理服务时,用户可以选择开启该功能,Triton会自动将到达服务器的分散的推理请求(通常是小批量)聚合成一个大批量,并输入到相应的模型实例中。做出推论。这样,GPU在执行更大批量的推理时可以获得更高的利用率,从而提高服务吞吐量。用户可以在 TI-ONE 平台中设置将多个请求合并为批次的等待时间,以平衡延迟和吞吐量。不仅如此,TI-ONE还利用Triton的并发模型执行功能,在每个NVIDIA GPU上同时部署相同或不同模型的多个模型实例,使得在单个模型相对轻量级时使用多个模型实例成为可能。并行执行充分利用GPU的计算资源,提高GPU利用率,实现更高的吞吐量。

图2. Triton Dynamic Batching机制示意图

最后,对于需要部署由多个模块组成的 AI 工作管道的应用场景,TI-ONE 正在与 NVIDIA 积极探索如何使用 Triton Ensemble Model 和 Triton Python Backend 来集成前处理和后处理带有AI模型的模块有序地连接在一起。其中,Triton Python Backend可以直接将现有的Python预处理和后处理代码封装成可以部署在Triton上的模块; Triton Ensemble Model是一种特殊的调度器,可以通过配置文件定义多个模块之间的连接关系。并在定义的工作管道上自动有序地调度推理请求。

目前,腾讯云TI平台TI-ONE采用NVIDIA Triton为多种不同行业解决方案提供高性能推理服务,包括工业质检、自动驾驶等业务场景涉及图像分类、对象检测和实例分割等人工智能任务。

通过Triton提供的多框架支持和扩展的TNN Backend,无论用户使用哪种框架来训练AI模型,都可以将推理服务部署在TI-ONE上,为算法工程师提供更大的选择自由度并节省模型转换。的费用。利用Triton的动态批处理机制和并发模型执行功能,TI-ONE在特定目标检测场景中部署FasterRCNN ResNet50-FPN模型。与使用Tornado部署框架相比,在NVIDIA T4 Tensor Core GPU上可实现高达31.6%的吞吐量提升。 ,如下图:

图 3. TI-ONE 中不同推理服务框架部署目标检测模型时实现的服务吞吐量对比

2022腾讯云

此图根据腾讯云提供数据

在另一图像分类业务中,TI-ONE使用Triton的Dynamic Batching机制,在1/2 T4 Tensor Core GPU上部署包括前后处理和模型推理的工作管道,结合TNN的推理加速,相比于Python HTTP Server 实现了高达 2.6 倍的延迟降低和高达 2.5 倍的吞吐量提升,如下表所示:

表 1. TI-ONE 中不同推理服务框架在部署图像分类模型时实现的服务性能比较

2022腾讯云

此表根据腾讯云提供的数据制作

未来,腾讯云TI平台将继续与NVIDIA团队合作,探索利用Triton部署复杂工作流程推理服务的解决方案,进一步为各行业的AI推理场景提供更高效、更低成本的推理平台。