众所周知,互联网数据的爆发式增长给数据中心的处理能力带来了巨大的挑战。

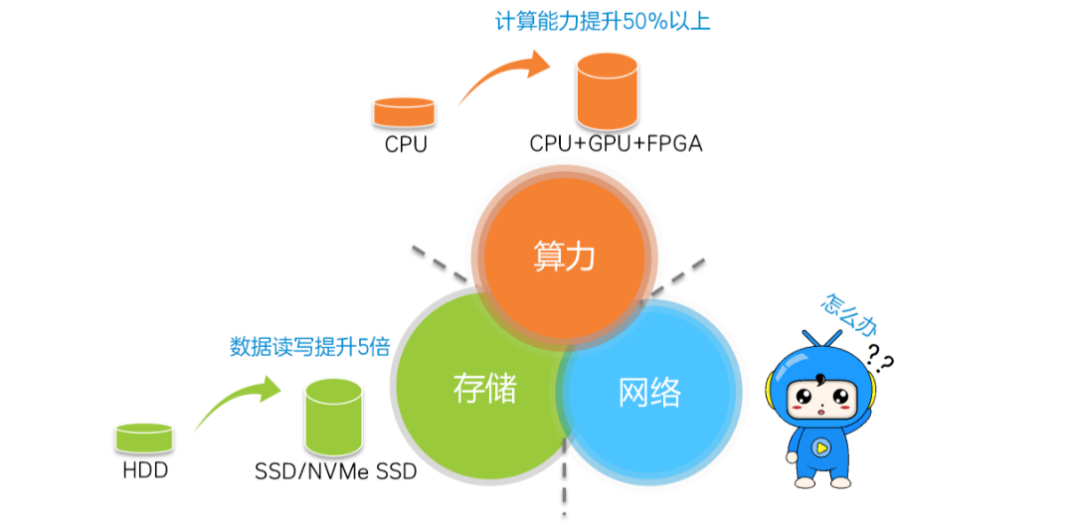

计算、存储和网络是推动数据中心发展的三驾马车。

计算随着CPU、GPU和FPGA的发展,计算能力得到了极大的提升。存储 随着闪存盘 (SSD) 的推出,数据访问延迟已显着降低。

但网络发展明显滞后,传输时延较高,逐渐成为数据中心高性能的瓶颈。

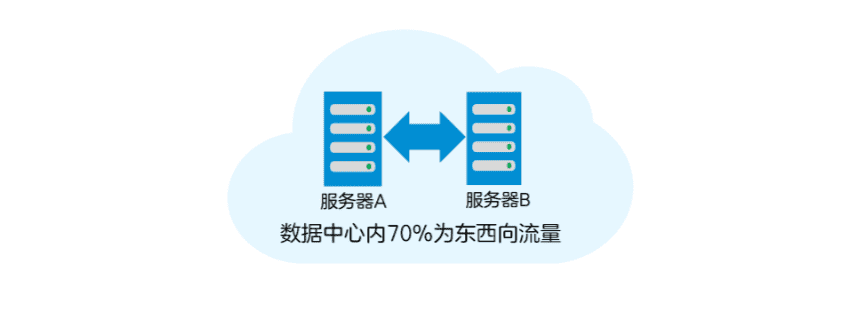

在数据中心内,70%的流量是东西向流量(服务器之间的流量)。这些流一般是数据中心进行高性能分布式并行计算时的处理数据流,通过TCP/IP网络进行传输。

如果服务器之间的TCP/IP传输速率提高,数据中心的性能自然也会相应提高。

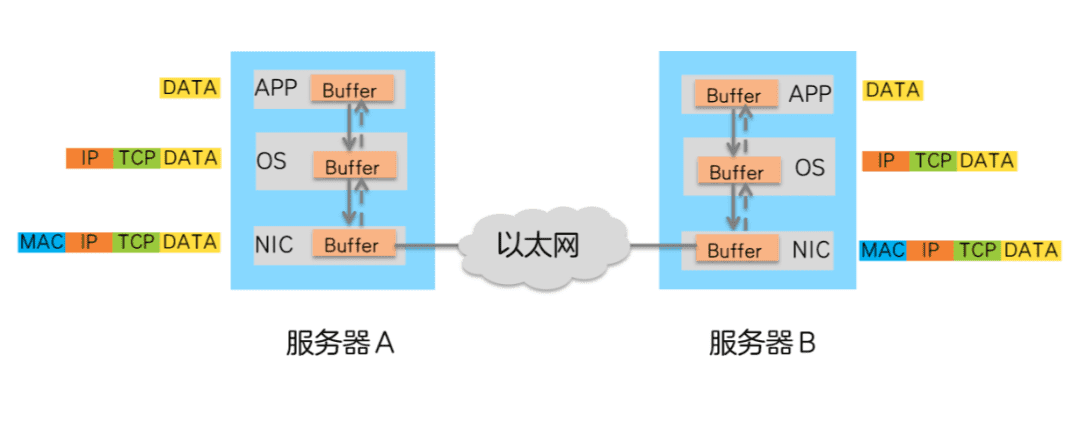

接下来我们就来看看服务器之间数据TCP/IP传输的过程,了解一下“时间都去哪儿了”,以便我们“对症下药”。

服务器之间的 TCP/IP 传输

在数据中心中,服务器A向服务器B发送数据的流程如下:

2. CPU 控制数据将 TCP 和 IP 标头添加到操作系统 (OS) 缓冲区。

3.添加TCP和IP头后的数据传输到网卡(NIC),并添加Ethernet头。

4、报文由网卡发送,通过以太网传输到服务器B网卡。

5、服务器B网卡卸载报文的以太网头后,传输给操作系统Buffer。

6. CPU 控制操作系统缓冲区中的数据包卸载 TCP 和 IP 数据包头。

7. CPU控制卸载的数据传输到APP Buffer中。

从数据传输过程可以看出,数据在服务器的Buffer中进行了多次复制,并且需要在操作系统中添加/卸载TCP和IP头。这些操作不仅增加了数据传输延迟,而且消耗了大量的CPU。资源不能很好满足高性能计算的需求。

那么,如何构建高吞吐量、超低延迟、低CPU开销的高性能数据中心网络呢?

RDMA技术可以做到。

什么是 RDMA

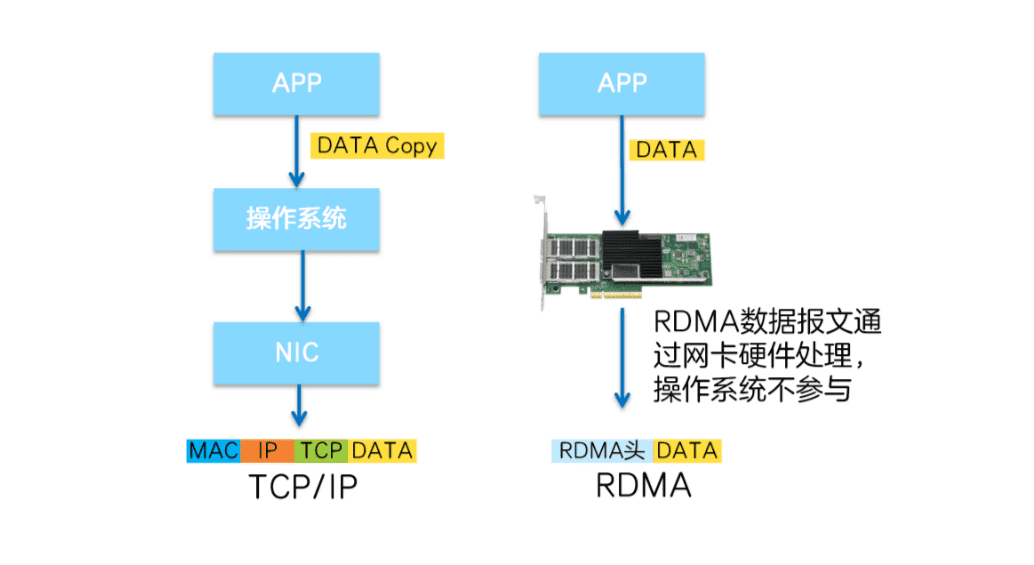

RDMA(Remote Direct Memory Access,远程直接地址访问技术)是一种新型内存访问技术,可以让服务器直接以高速读取速度写入其他服务器的内存数据,无需经过操作系统/CPU的耗时处理。

RDMA并不是一项新技术,已广泛应用于高性能(HPC)科学计算中。随着数据中心高带宽、低时延的发展需求,RDMA逐渐开始应用于数据中心某些需要高性能的场景。

例如,2021年大型线上商城的双十一交易额再创新高,达到超过5000亿,较2020年增长近10%。如此巨大的交易额背后是海量的。数据处理。网上商城采用RDMA技术,支持高性能网络,保障双十一购物顺利。

我们来看看 RDMA 实现网络低延迟的技巧。

RDMA将服务器应用程序数据直接从内存传输到smart网卡(固化的RDMA协议)。智能网卡硬件完成RDMA传输消息封装,释放操作系统和CPU。

这赋予了 RDMA 两大优势:

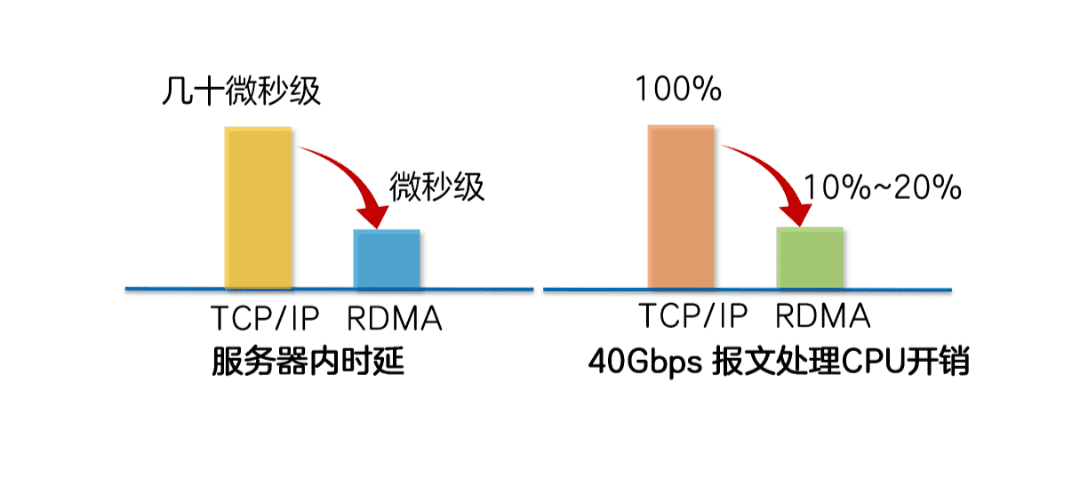

零复制:不需要将数据复制到操作系统内核态并处理数据包头,传输延迟将显着降低。

内核旁路(Kernel Bypass)和协议Offload(Protocol Offload):不需要操作系统内核参与,数据路径中没有繁琐的头处理逻辑。这不仅减少了延迟,还大大节省了时间。 CPU资源。

三大RDMA网络

目前,RDMA网络大致有三种类型,即InfiniBand、RoCE(RDMA over Converged Ethernet,RDMA over Converged Ethernet)和iWARP(RDMAover TCP,互联网广域RDMA协议)。

RDMA原本是Infiniband网络架构独有的,从硬件层面保证可靠传输。 RoCE和iWARP都是基于以太网的RDMA技术。

InfiniBand

InfiniBand是专门为RDMA设计的网络。

采用Cut-Through转发模式(直通转发模式),减少转发时延。

基于信用的流控机制(credit-based flow control Mechanism)保证不丢包。

需要InfiniBand专用网卡、交换机、路由器,网络建设成本最高。

RoCE

传输层是InfiniBand协议。

RoCE有两个版本:RoCEv1基于以太网链路层实现,只能在L2层传输; RoCEv2基于UDP承载RDMA,可以部署在三层网络中。

需要支持RDMA专用智能网卡,不需要专用交换机和路由器(支持ECN/PFC等技术,降低丢包率),建网成本最低。

iWARP

传输层是iWARP协议。

iWARP是以太网TCP/IP协议的TCP层实现,支持L2/L3层传输。大规模网络TCP连接消耗大量CPU,因此应用较少。

iWARP只需要网卡支持RDMA,不需要专用的交换机和路由器。网络建设成本介于InfiniBand和RoCE之间。

Infiniband技术先进,但价格较高,应用仅限于HPC高性能计算领域。随着RoCE和iWARPC的出现,降低了RDMA的使用成本,促进了RDMA技术的普及。

在高性能存储和计算数据中心使用这三种类型的RDMA网络可以显着降低数据传输延迟,并为应用程序提供更高的CPU资源可用性。

其中,InfiniBand网络为数据中心带来极致性能,传输延迟低至100纳秒,比以太网设备的延迟低一个数量级。

RoCE和iWARP网络为数据中心带来超高性价比。它们承载基于以太网的RDMA,充分利用RDMA的高性能和低CPU占用率。同时,网络建设成本较低。

基于UDP协议的RoCE比基于TCP协议的iWARP具有更好的性能。结合无损以太网的流控技术,解决敏感丢包问题。 RoCE网络已广泛应用于各行业的高性能数据中心。

结论

随着5G、人工智能、工业以及互联网等新领域的发展,RDMA技术的应用将越来越普及,RDMA将成为数据中心的高科技强国。性能的主要贡献者。

审稿编辑:刘庆