这次我将分享三篇在ICLR2021提交的文章,涉及知识图谱与训练模型和命名实体识别(NER)相结合的研究工作。

文章概述

知识图谱和语言理解的联合预训练(JAKET:Joint Pre-training of Knowledge Graph and Language Understanding)。本文提出了知识图谱和文本的联合训练框架。通过使用 RoBERTa 作为语言模型,将上下文编码信息转移到知识图谱中。同时,借助图注意力模型将知识图谱的结构化信息反馈给语言。模型,从而实现知识图模型和语言模型的循环交替训练,使得预训练的模型在知识图的指导下能够快速适应新的领域知识。

语言模型是开放知识图。本文提出了一种匹配与映射(MAMA)模型,可以自动构建知识图谱。它利用预先训练的语言模型中的注意力权重来提取语料库中实体之间的关系,并基于现有的模式框架自动构建开放性。知识图谱。

命名实体识别中的无标签实体问题研究(Empirical Analysis of Unlabeled Entity Problem in Named Entity Recognition)。论文探讨了未标记实体问题对NER实验指标的影响,并提出了负采样策略。通过改进损失函数,将标记实体作为负样本训练,从而大大改善了未标记实体问题对NER实验的影响。指标的影响。

论文详情

1

论文动机

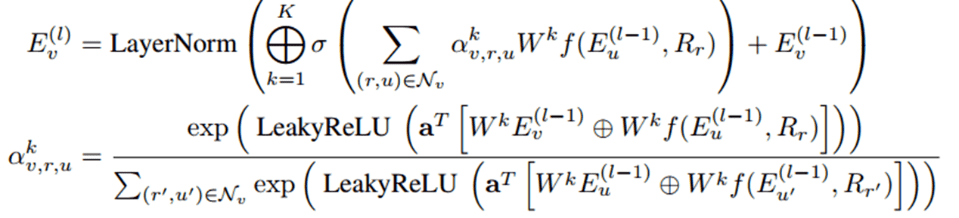

现有的知识图谱与预训练模型相结合的研究工作仍然存在挑战:当预训练模型与新领域的知识图谱进行微调时,语言模型很难有效地学习结构化实体关系语义信息。同时,知识图谱的理解和推理能力也需要上下文的帮助。基于此,论文提出了一种联合预训练框架:JAKET,通过对知识图谱和语言同时建模,实现两个模型之间的信息互补和交替训练。方法1.知识模块(KM)知识模块主要对知识图进行建模并生成包含结构化信息的实体表示。使用图注意力模型和组合算子的思想来聚合实体嵌入和关系嵌入信息。实体V在L层的嵌入信息传播公式为:

考虑到计算过程中可能出现的实体数量爆炸问题,实验采用设置小批量现场采样的方法来获取多跳邻居集。 2.语言模块(LM) 语言模块主要对文本进行建模,学习文本的嵌入表示。 RoBERT-base用作预训练模型。 3.解决循环依赖问题(Solve the syclic dependency) 由于LM和KM之间互相传递信息,因此在训练过程中存在循环依赖问题,不方便后续的计算优化。论文提出了一种分解语言模型来解决这个问题,即将LM分解为LM1和LM2子模块,并使用RoBERT的前6层和后6层分别作为LM1和LM2,实现LM1的联合训练, KM 和 LM2。整体框架如下图所示。

实验结果论文对实体类别预测、关系类别预测、词块掩码预测和实体掩码预测四个任务进行了预训练,并对小样本关系分类、KGQA和实体分类三个下游任务进行了实验。实验结果如下图所示:

从实验结果可以看出,论文提出的JAKET可以在三个任务中进一步提升性能,联合预训练可以有效降低模型对下游训练数据的依赖。

2

论文动机

知识图谱的构建方法通常需要人工辅助,但人力成本过高;

同时,BERT等预训练模型通常是在超大规模的语料库上进行训练。训练出来的模型本身就包含了常识性知识,可以促进上层的其他应用。

因此,本文提出一种无监督匹配与映射(MAMA)模型,将预训练语言模型中包含的知识转换为知识图谱。

方法

1. 匹配

Match阶段主要是自动提取三元组。对于输入文本,使用开源工具提取实体,并将实体配对为头实体和尾实体。预训练模型的注意力权重用于提取实体对之间的关系。使用波束搜索方法搜索从起始实体到结束实体的多条路径,得到多个候选三元组。然后通过设置一些限制规则来过滤掉非常规的三元组,就得到了用于构建知识图谱的三元组。

2. 地图

Map阶段主要将Match阶段提取的三元组映射到知识图谱。使用成熟的实体链接和关系映射技术将三元组映射到现有的固定模式映射。对于部分映射或完全不匹配的三元组,构建开放模式知识图谱,最后将两类知识图谱进行融合,得到灵活的开放知识图谱。

整体框架如下:

论文中使用BERT-large自动构建维基百科语料库的知识图谱。图形效果如下:

实验结果

论文在 TAC KBP 和 Wikidata 数据集上进行槽填充任务实验。

TAC KBP数据集上的结果如下:

基于TAC KBP数据集的实验结果主要包括两点:第一,MAMA模型可以提高知识图谱的槽位填充效果;第二,MAMA模型可以提高知识图谱的槽位填充效果。其次,更大/更深的语言模型可以提取更高质量的知识图谱。

Wikidata数据集上的结果如下:

基于Wikidata数据集的实验结论一方面表明MAMA可以扩展到更大的语料库,另一方面MAMA可以从更大的语料库中提取出更完整的知识图谱。

3

论文动机

未标记实体问题是命名实体识别(NER)任务中的常见问题,并且在实际情况中无法完全避免该问题。既然无法彻底解决无标签实体的问题,那么这个问题会对NER模型产生影响吗?如果影响很大,如何将这种负面影响降到最低?

基于上述问题,本文分析了无标签实体问题对NER实验指标的影响及其原因,并提出了鲁棒负采样策略,使得模型能够在无标签实体概率极低的状态下进行训练。 ,从而提高实体标注效果。

方法

1.综合数据集

通过按照一定的概率随机屏蔽标注良好的CoNLL-2003和OntoNotes5.0数据集中的标注实体,得到合成的不完善标注数据集。

2.指标

文章设计了两个指标:侵蚀率(erosionrate)和误导率(misguidancerate)来衡量NER中未标记实体问题的影响。

侵蚀率代表实体注释减少对NER指数下降的影响。

误导率代表未标记实体作为负样本时对NER指数下降的影响。

3.负采样

文章采用负采样进行降噪,对所有非实体进行负采样,采样负样本来计算损失函数。改进后的损失函数如下:

前半部分表示标记实体集合的损失,后半部分表示负采样实体集合的损失。文章整体模型框架如下图所示。整体模型是BERT/LSTM编码+softmax的思想。

实验结果

文章在合成数据集上进行NER任务实验,分析未标记问题的影响以及负采样的训练效果。

首先是分别基于CoNLL-2003和OntoNotes5.0合成数据集的实验结果:

从图中可以看出,随着实体屏蔽概率p的增加,即未标记实体数量的增加,NER指数显着下降;当p很低时,误导率较高,而侵蚀率影响较小,说明将未标记实体标记为负样本进行训练会对NER指数的下降产生很大影响。减少实体标注量对指数下降影响更小

其次,分别在全注释数据集和真实数据集上将文中提出的负采样训练模型与其他SOTA模型进行了比较。实验结果如下:

结果表明,该模型在完全注释的数据集上的效果与其他模型没有太大区别,并且在真实数据集上的效果远好于其他模型,因此该模型的整体效果是最好的。

总结

本次解读的三篇论文主要集中在知识建模和信息抽取的研究点上。感知知识图谱与语言模型相结合的相关研究趋势是尝试使用同一个编码系统对语言模型中的上下文信息和知识图谱中的结构化语义信息同时进行编码和训练,从而实现知识融合或知识融合。矿业。另外,第三篇文章主要想给广大从事知识图谱研究的研究者分享一个命名实体识别的技术和思路。当面对标注质量较低的数据集时,你可能想尝试负采样方法。

以上是本期复旦DISC的论文分享内容。欢迎您的批评和交流。

原标题:【论文解读】ICLR2021知识建模与信息抽取

文章来源:【微信公众号:深度学习自然语言处理】欢迎添加关注!转载文章时请注明出处。

责任编辑:haq

-->