2023年,以ChatGPT为代表的AIGC大模型全面崛起,成为了整个社会关注的焦点。 大模型表现出了强悍的自然语言理解能力,刷新了人们对AI的认知,也掀起了新一轮的“算力军备竞赛”。 大家都知道,AIGC大模型的入局门槛是很高的。玩AI的三大必备要素——算力、算法和数据,每一个都意味着巨大的投入。 以算力为例。ChatGPT的技术底座,是基于微调后的GPT3.5大模型,参数量多达1750亿个。为了完成这个大模型的训练,微软专门建设了一个AI超算系统,投入了1万个V100 GPU,总算力消耗约3640 PF-days(即假如每秒计算一千万亿次,需要计算3640天)。 业内头部厂商近期推出的大模型,参数量规模更是达到万亿级别,需要的GPU更多,消耗的算力更大。 这些数量庞大的GPU,一定需要通过算力集群的方式,协同完成计算任务。这就意味着,需要一张超高性能、超强可靠的网络,才能把海量GPU联接起来,形成超级计算集群。 那么,问题来了,这张网络,到底该如何搭建呢?

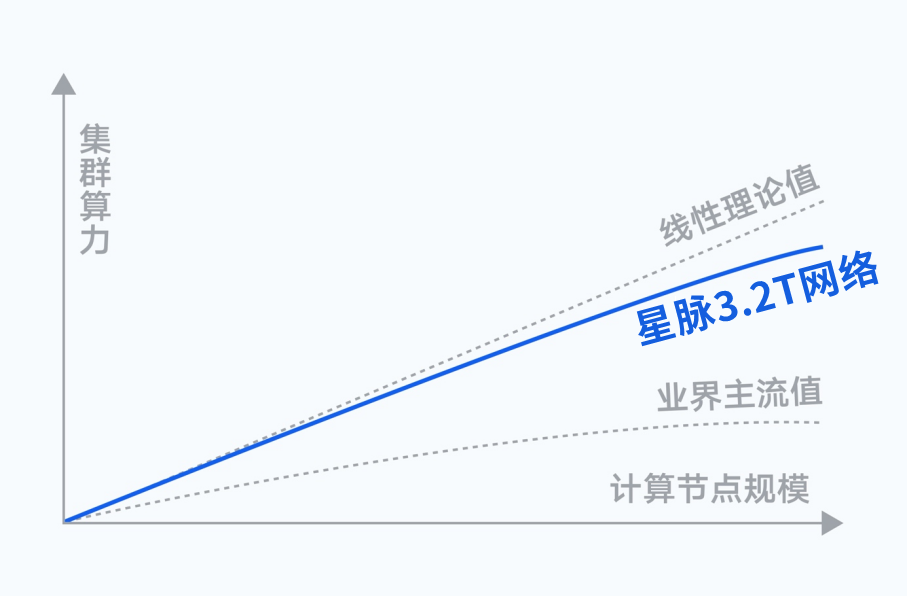

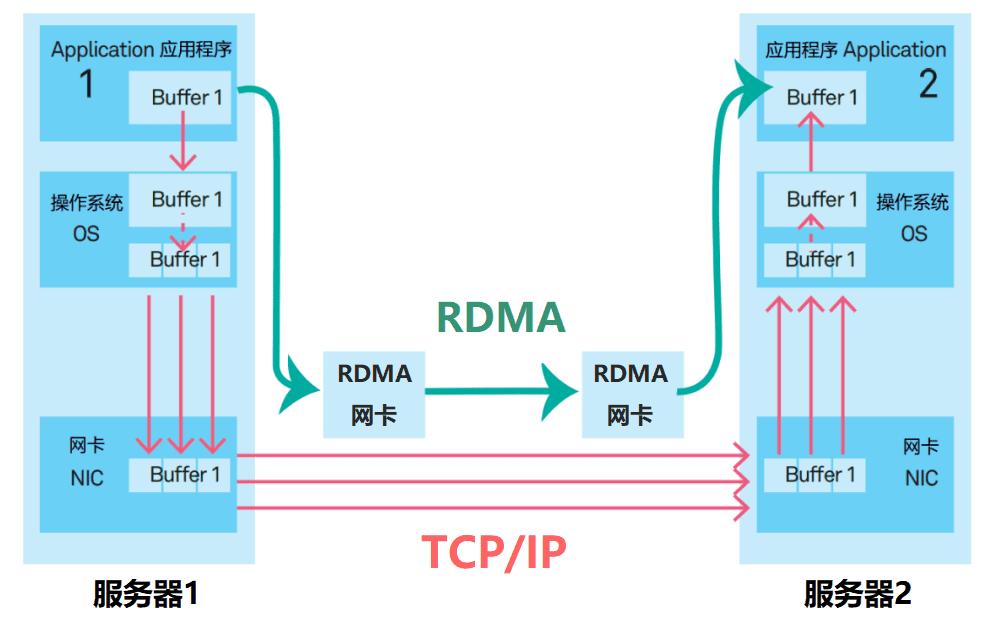

高性能网络的挑战 想要建设一张承载AIGC大模型的网络,需要考虑的因素非常多。 首先,是网络规模。 刚才我们也提到,AI训练都是10000个GPU起步,也有的达到十万级。从架构上,目标网络就必须hold得住这么多的计算节点。而且,在节点增加的同时,集群算力尽量线性提升,不能引入过高的通信开销,损失算力。 其次,是网络带宽。 超高性能的GPU,加上千亿、万亿参数的训练规模,使得计算节点之间的通信量,达到了百GB量级。再加上各种并行模式、加速框架的引入,节点之间的通道带宽需求会更高。 传统数据中心通用的100Gbps带宽接入,根本满足不了这个需求。我们的目标网络,接入带宽必须升级到800Gbps、1.6Tbps,甚至更高。 第三,流量调控。 传统的网络架构,在应对AI大模型训练产生的数据流时,存在缺陷。所以,目标网络需要在架构上做文章,更好地控制数据流路径,让节点和通道的流量更均衡,避免发生拥塞。 第四,协议升级。 网络协议是网络工作的行为准则。它的好坏,直接决定了网络的性能、效率和延迟。 传统数据中心的TCP/IP协议,早已已无法满足高性能网络的大带宽、低时延需求。性能更强的IB(InfiniBand)协议、RDMA协议,已然成为主流。有实力的厂家,还会基于自家硬件设备,自研更高效的协议。 第五,运维简化。 这就不用多说了。超大规模的网络,如果还是采用传统运维,不仅效率跟不上,还会导致更长的故障恢复周期,损失算力,损失资金。 目前,行业里的“大模头”们,都会根据自己技术和资金实力,选择商用网络组网,或者自研网络协议。 大家心里很清楚,想要赢得这场比赛,除了算力芯片足够强之外,网络的性能表现是至关重要的。网络越强,集群的算力提升就越大,完成模型训练的时间就越短,成本也就越低。

星脉网络,鹅厂的算力集群杀手锏 对于AI大模型这场热潮,腾讯当然不会缺席。他们推出了业界领先的高性能计算网络架构——星脉。 腾讯深耕互联网行业20多年,从QQ到微信,他们的超大规模业务承载能力,可以说是行业顶尖的。在网络技术的理解和驾驭能力上,也是世界领先水平。而星脉,则是他们多年技术研究的精髓,是真正的杀手锏。 根据实测,星脉实现了AI大模型通信性能的10倍提升、GPU利用率提升40%、通信时延降低40%。 基于全自研的网络硬件平台,星脉可以实现网络建设成本降低30%,模型训练成本节省30%~60%。

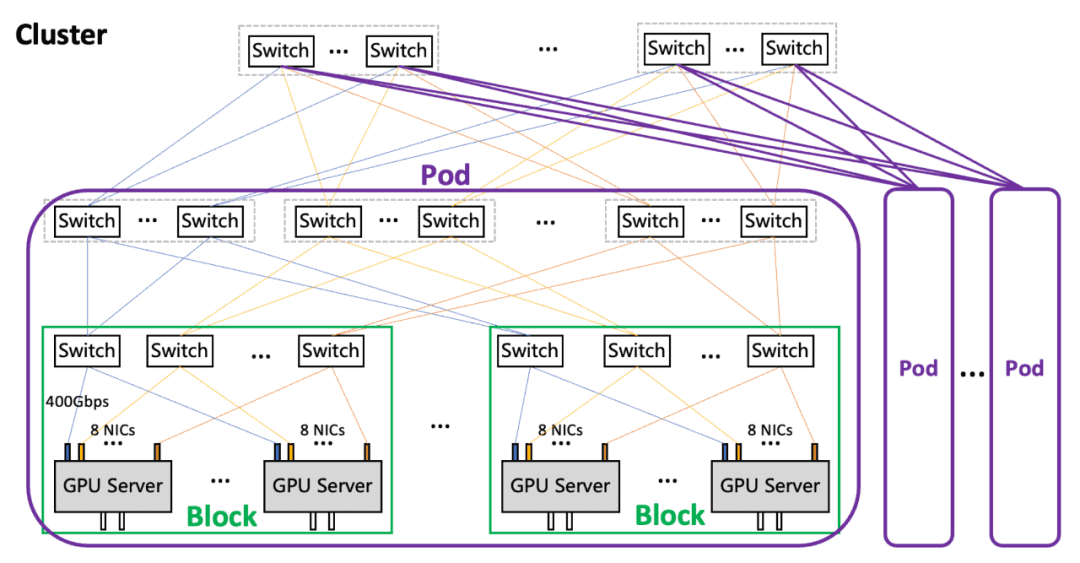

网络规模

在组网架构上,星脉网络采用无阻塞胖树(Fat-Tree)拓扑,分为Block-Pod-Cluster三级。

网络带宽

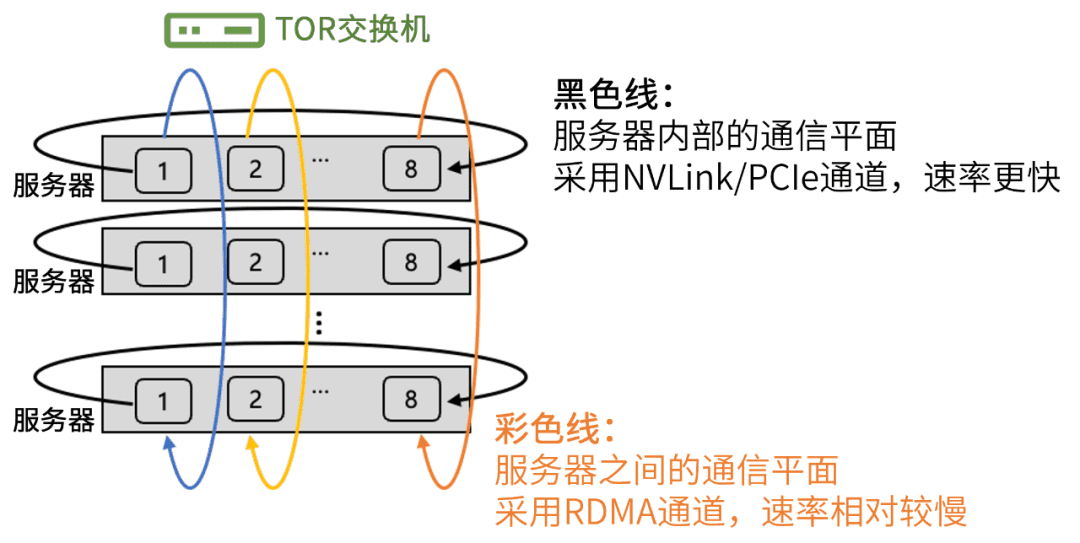

腾讯星脉网络为每个计算节点提供了3.2T的超高通信带宽。 单个服务器(带有8个GPU)就是一个计算节点。每个服务器有8块RoCE网卡。每块网卡的接口速率是400Gbps。 RoCE,是RDMA over Converged Ethernet(基于聚合以太网的RDMA)。RDMA(远程直接GPU通信访问)我们以前介绍过很多次。它允许计算节点之间直接通过内存进行数据传输,无需操作系统内核和CPU的参与,能够大幅减小CPU负荷,降低延迟,提高吞吐量。

流量调控

为了提升集群的通信效率,星脉网络对通信流量路径进行了优化,引入了“多轨道流量聚合架构”。 该架构将不同服务器上位于相同位置的网卡,都归属于同一个ToR switch(机柜顶部的汇聚交换机)。整个计算网络平面,从物理上被划分为8个独立并行的轨道平面。

协议升级

星脉网络采用的“自研端网协同协议TiTa”,可以提供更高的网络通信性能,非常适合大规模参数模型训练。 TiTa协议内嵌拥塞控制算法,可以实时监控网络状态并进行通信优化。它就好比是一个智能交通管理系统,可以让网络上的数据传输更加通畅。

部署和运维简化

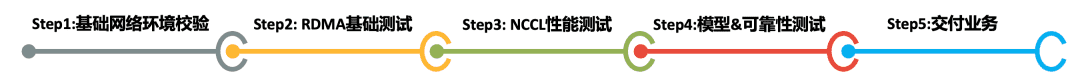

算力集群网络越庞大,它的部署和维护难度也就越大。 为了提升星脉网络的可靠性,腾讯自研了一套全栈网络运营系统,实现了“端网部署一体化”、“一键故障定位”、“业务无感秒级网络自愈”,对网络进行全方位保驾护航。 先看看“端网部署一体化”。 部署一直都是高性能网络的痛点。在星脉网络之前,根据统计,90%的高性能网络故障问题,是因为配置错误导致。原因很简单,网卡的配置套餐太多(取决于架构版本、业务类型和网卡类型),人为操作很难保证不出错。 腾讯的解决方法,是将配置过程自动化。 他们通过API的方式,实现单台/多台交换机的并行部署能力。 在正式部署前,系统会自动对基础网络环境进行校验,看看上级交换机的配置是否合理等。 然后,识别外部因素,自动选择配置模板。 配置完成后,为了保证交付质量,运营平台还会进行自动化验收,包括一系列的性能和可靠性测试。