大型语言模型(LLM)具有较强的常识理解能力和较强的逻辑推理能力,但只能处理文本数据。发布的GPT4虽然具备图像理解能力,但尚未开放多模态输入接口,也不会透露该模型的任何技术细节。因此,现阶段如何利用LLM来做一些多模态的任务还是有一定的研究价值的。

本文总结了近两年基于LLM的视觉语言任务的一些工作,分为4类:

以LLM为理解中心调用多模态模型,如VisualChatGPT(2023)[1]、MM-REACT(2023)[2];

将视觉转换为文本作为LLM的输入,如PICA(2022)[3]、PromptCap(2022)[4]、ScienceQA(2022)[5];

使用视觉模态影响LLM解码,例如ZeroCap[6]、MAGIC[7];

Frozen LLM,训练视觉编码器以及其他适应LLM的附加结构,如Frozen[8]、BLIP2[9]、Flamingo[10]、PaLM-E[11];

接下来,每个类别都会选取有代表性的职位进行简单介绍:

1.以LLM为理解中心调用多模态模型

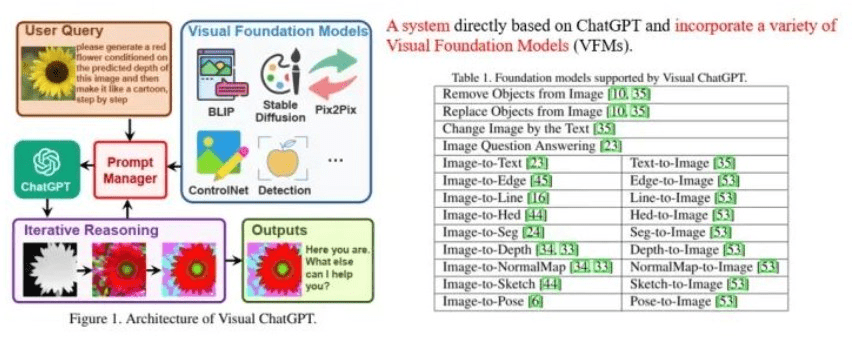

以 Microsoft Visual ChatGPT[1] 为例。其目标是使系统不仅可以与人们进行与视觉内容相关的对话,还可以绘制和修改图片。为此,Visual ChatGPT以ChatGPT作为与用户沟通的理解中心,集成了多个视觉基础模型(Visual Foundation Models),并通过提示工程(即Prompt Manager)告诉ChatGPT每个基础模型的用法和输入输出格式,允许 ChatGPT 决定如何调用这些模型来满足用户需求,如图 1 所示。

图1:Visual ChatGPT系统示意图

稍后微软另一个团队提出的MM-REACT[2]也有同样的想法。主要区别在于提示工程的设计,MM-REACT更注重对视觉的一般性理解和解释,包括很多微软Azure的API,比如名人识别、账单识别、Bing搜索等。

2. 将视觉转换为文本作为LLM的输入

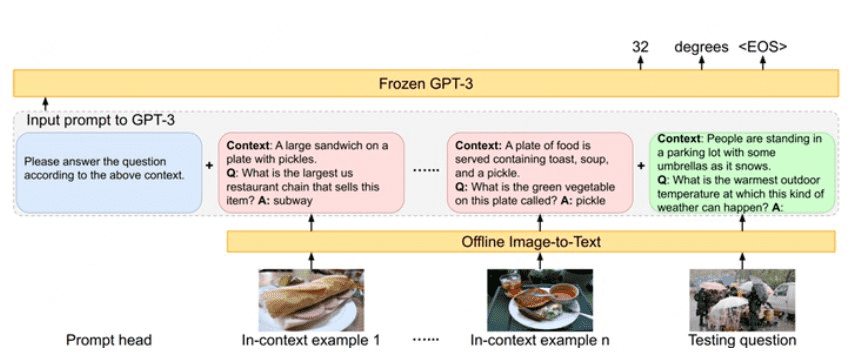

以PICA[3]为例,其目标是充分利用LLM的海量知识来做Knowled基于ge的QA。给定一张图片和一个问题,之前的工作主要从外部来源(例如维基百科)检索相关背景知识,以协助生成答案。然而PICA尝试以文本的形式描述图片,直接和问题放在一起作为LLM的输入,让LLM通过in-context学习直接生成答案,如图如图2所示。

图2:PICA方法示意图

情境学习的效果更多地依赖于实例/演示的质量ti。为此,PICA作者利用CLIP选取了16个在问题和图片方面与当前测试样本最接近的训练样例作为例子。

3. 使用视觉模态影响LLM解码

以MAGIC[3]为例,其目标是让LLM完成图像字幕的任务。其核心思想是在生成每个单词时,增加生成视觉相关单词的概率。公式如图3所示。

图3:MAGIC解码公式示意图

公式主要由三部分组成:1)LLM预测单词的概率; 2)退化惩罚(橙色); 3)视觉相关性(红色)。退化惩罚主要希望生成的词能够带来新的信息量。视觉相关性部分基于CLIP计算所有候选词与图片之间的相关性,将softmax后的概率作为预测概率。

4. 训练视觉编码器等附加结构以适应LLM

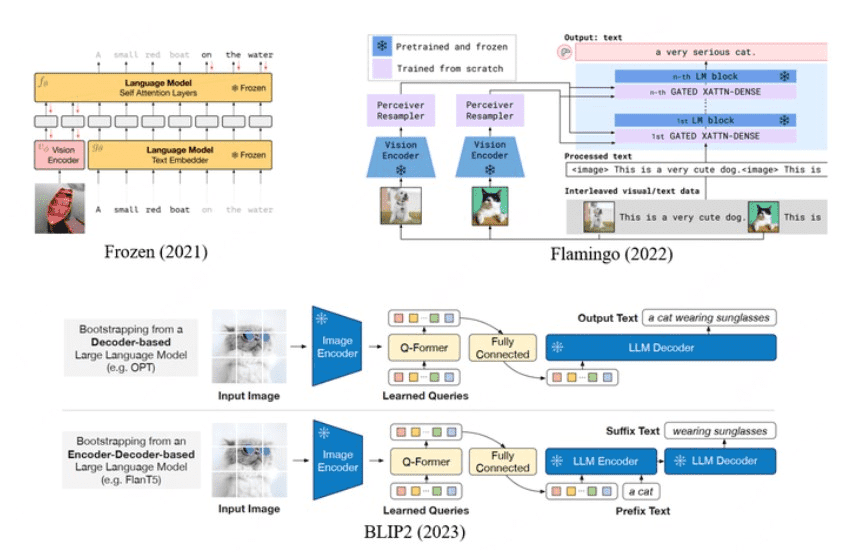

这部分工作目前最受关注,因为它有潜力“以远低于多模态通用模型训练的成本将LLM扩展到多模态模型”。 DeepMind 2021 年的《Frozen》、2022 年的 Flamingo、以及 Saleforce 2023 年的 BLIP2 都沿着这条路线,如图 4 所示。

图4:Frozen、Flamingo、BLIP2的示意图。

在 Frozen 训练期间,图像被编码为 2 个视觉标记,作为 LLM 的前缀。目标是生成后续文本,概念字幕用作训练语料库。 Frozen通过few-shot学习/上下文学习的下游VQA和图像分类效果还不是很强,但已经观察到了一些多模态上下文学习能力。

为了解决视觉特征图大小可能不一致的问题(特别是对于多帧视频),Flamingo使用Perceiver Resampler(类似于DETR的解码器)生成固定长度的特征序列( 64 个标记),并且在 LLM 的每一层之前都有一个额外的 cross 注意力层,该层对视觉特征执行注意力计算,以实现更强的视觉相关性生成。 Flamingo的训练参数比Frozen高很多,因此使用了大量的数据:1)MultiModal MassiveWeb(M3W)数据集:从4300万个网页收集的混合图像和文本数据,转换为交叉-排列图像和文本序列(根据图像在网页中的相对位置,确定转换为序列后

BLIP2采用与Flamingo类似的视觉编码结构,但采用更复杂的训练策略。它由两个阶段的训练组成。第一阶段主要是让视觉编码器学习提取最关键的视觉信息。训练任务包括图文对比学习、基于图像的文本生成和图文匹配;第二阶段主要是提取最关键的视觉信息。视觉编码结构的输出适配LLM,训练任务也是语言建模。 BLIP2的训练数据包括MSCOCO、Visual Genome、CC15M、SBU、来自LAION400M的115M图片以及BLIP在网络图像上生成的描述。 BLIP2已经实现了强大的零镜头字幕和VQA能力,但作者提到其上下文学习能力尚未被观察到,即输入样本无法提高其性能。作者分析是因为训练数据不包含Flamingo使用的交错的图像和文本数据。不过,《冰雪奇缘》并没有使用这类数据,但它也观察到了一定的情境学习能力。因此,多模态上下文学习能力可能与训练数据、训练任务和位置编码方法有关。

总结

“以LLM为理解中心调用多模态模型”可以快速、轻松地部署基于LLM的多模态理解和生成系统。难点主要在于调度不同多模态模型的即时工程设计;

“将视觉转换为文本作为LLM的输入”和“使用视觉模态影响LLM的解码”可以直接使用LLM做一些多模态任务,但上限可能会低一些,其性能取决于外部多模态模型。能力;

“训练视觉编码器等附加结构以适应LLM”具有更高的研究价值,因为它有潜力将任何模态整合到LLM中,实现真正的多模态模型。难点在于如何实现较强的情境学习能力。

审稿编辑:刘庆